複数のAIエージェント:LangGraphとLangChainを使用したマルチエージェントワークフローの作成

Tags: staged for publishing

Created: May 11, 2024 11:49 AM

Updated: May 12, 2024 11:36 PM

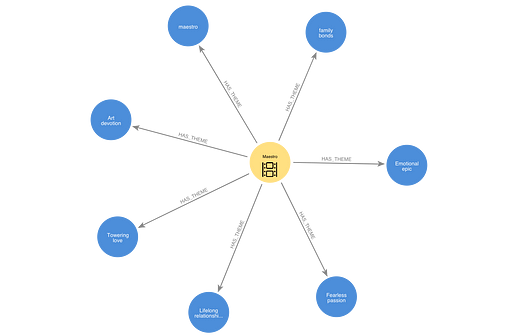

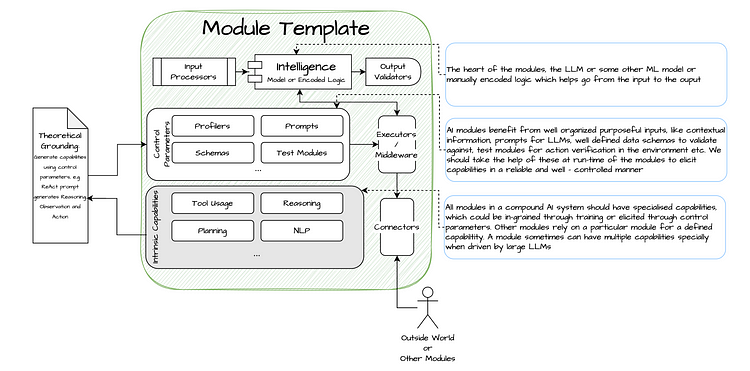

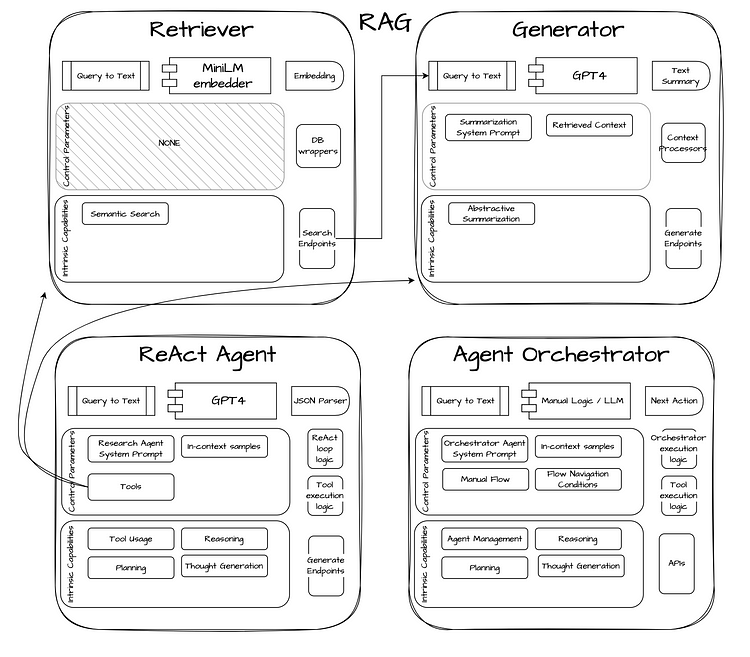

自己反射型AI (Self-Reflective AI)は、ジェネレーターを使用して出力を作成し、リフレクターを使用してそれをチェックします。両方ともLarge Language Model(LLM)を使用しますが、プロンプトは異なり、自己チェック型AIが作成されます。

これは、LangChainのLangGraphにより可能になります。これにより、同じLLMが2つの異なる役割で使用できます。

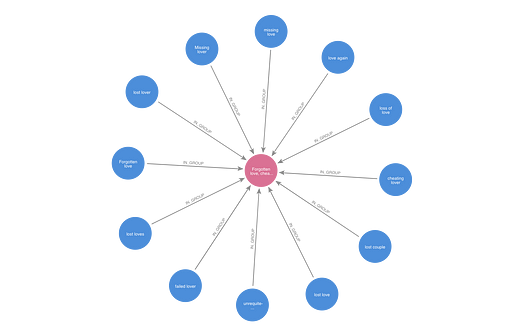

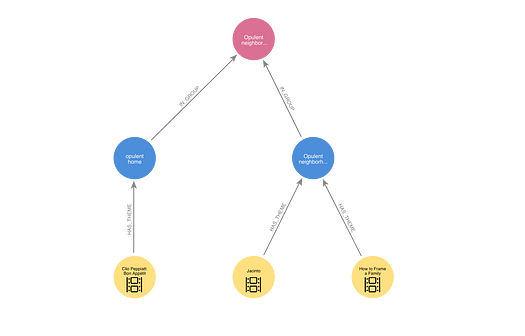

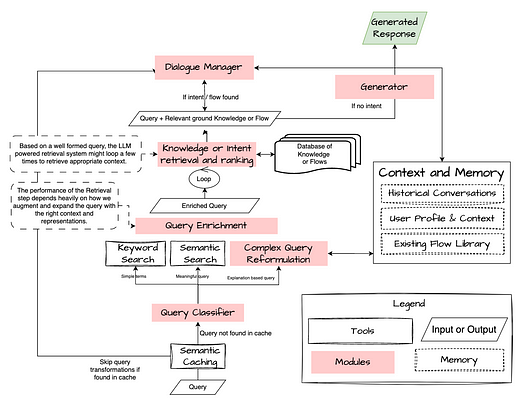

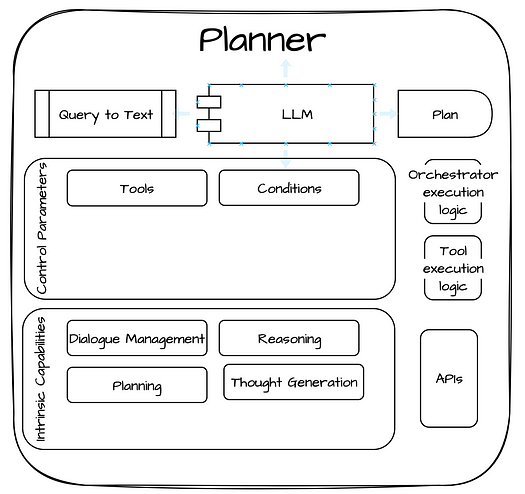

LangGraphはまた、マルチエージェントワークフローの構築を支援します。ここでは、LLMは複数の役割を果たすことができ、それぞれが異なるAIエージェントとして働きます。この設定はマルチエージェントと呼ばれます。

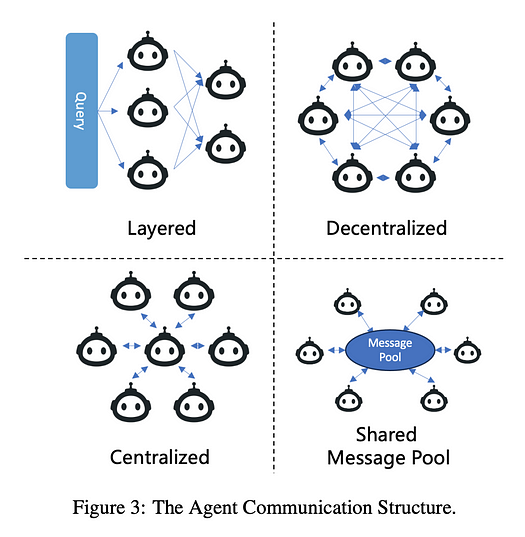

マルチエージェントシステムでは、それぞれがLLMによって動かされる別々のアクターが特定の方法で接続されています。

各エージェントは、自分のプロンプト、LLM、ツール、カスタムコードを持つことができ、他のエージェントと共同作業を行うことができます。しかし、同じLLMも与えられたプロンプトに基づいて異なる役割を果たすことができます。

LangGraphは、2つ以上のエージェントをグラフとして接続させることを可能にするため、マルチエージェントワークフローを作成するのに最適です。各エージェントは独立しており、エージェント間の接続(エッジ)は情報の流れをガイドする制御条件を持つことができます。各エージェントの状態は、この流れの間に情報で更新することができます。

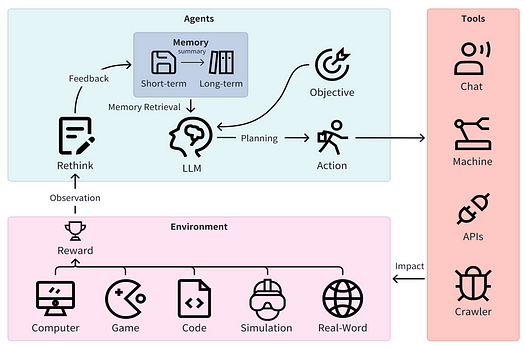

人間が協力して働くように、マルチエージェントワークフローの異なるAIエージェントは、メッセージの共有スクラッチパッドを使用して通信します。これにより、各エージェントは他のエージェントの作業と各ステップを視認することができます。

異なるAIエージェントはすべて同じLLMに基づいている可能性がありますが、役割は異なります。

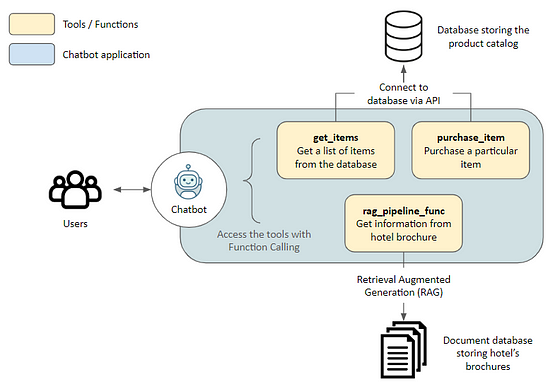

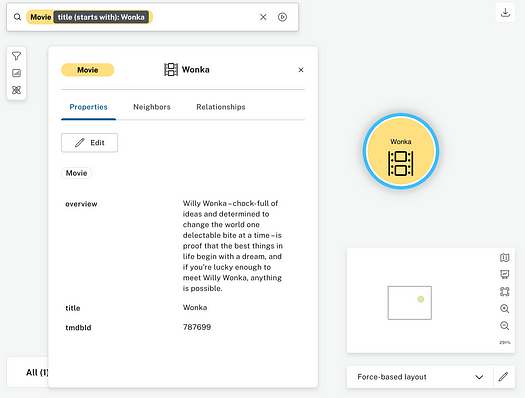

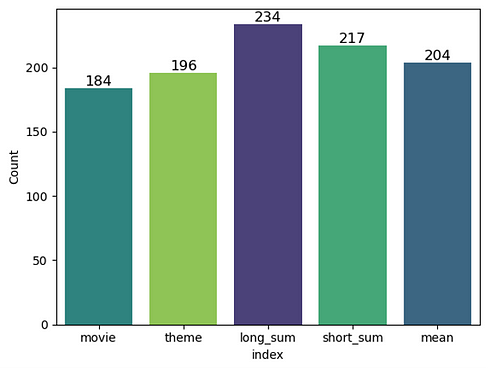

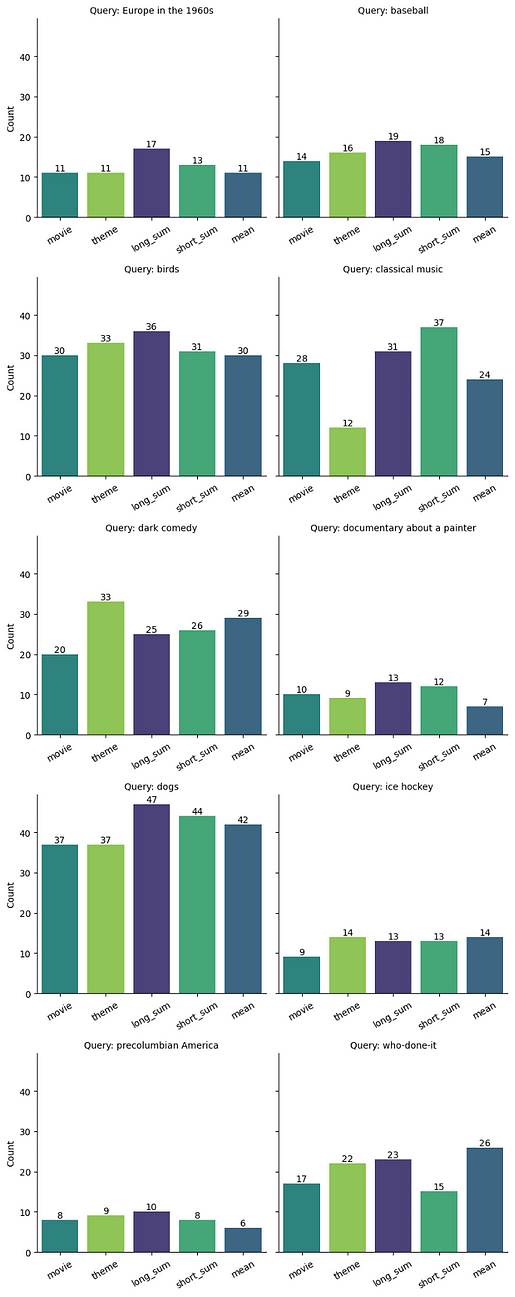

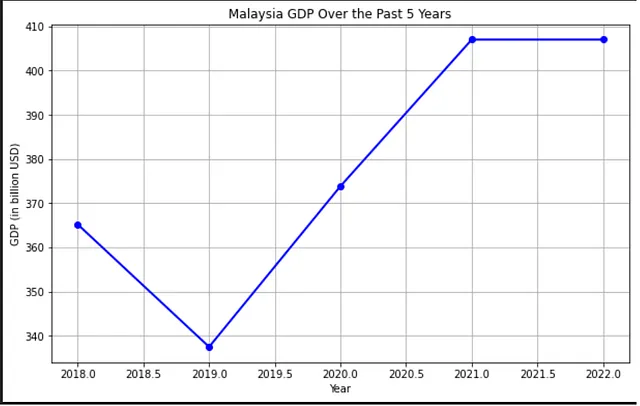

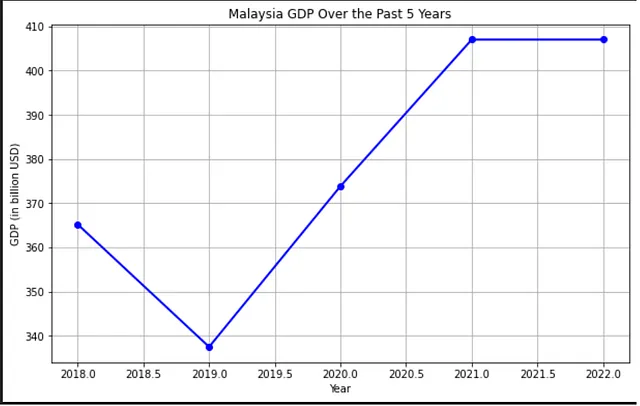

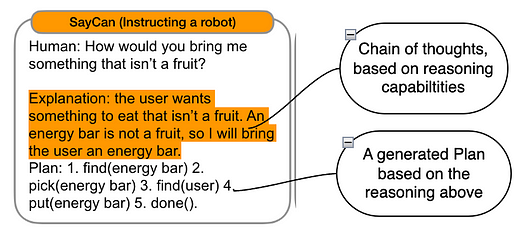

さて、過去5年間のマレーシアのGDPを示すチャートを作成するためのマルチエージェントワークフローを作成しましょう。

これには、オンラインで過去5年間のマレーシアのGDPデータを調査する研究者と、研究者のデータからPythonコードを使用してチャートを作成するチャートジェネレーターが必要です。

したがって、エージェントは次のとおりです:

- 研究者 - インターネットを使用して問題を調査します。

- チャートジェネレーター - 研究者のデータを使用してチャートを作成します。

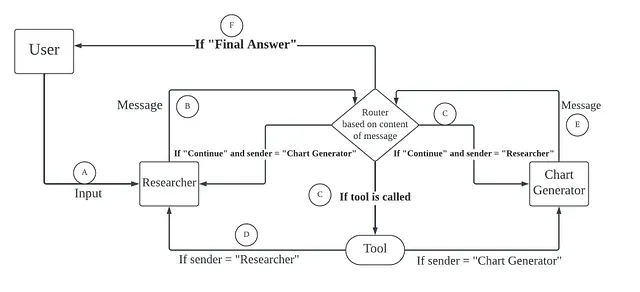

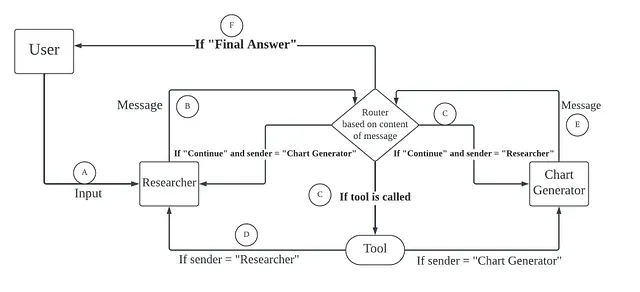

エージェントノードとその接続を示すグラフの設計図を作成します。

- ユーザーがリサーチャーに入力を提供します。

- リサーチャーはこの入力をルーターに渡します。

- ルーターは、入力に基づいてツールを使用するか、メッセージをチャートジェネレーターに送ります。

- ツールは入力を処理し、応答をリサーチャーに戻します。リサーチャーは再度ツールを使用するか、メッセージをチャートジェネレーターに送るかもしれません。ルーターもメッセージに従って同様に行います。

- チャートジェネレーターはその返答をルーターに送り、ルーターは再度ツールを使用するか、リサーチャーに返すかします。

- 最後に、リサーチャーやチャートジェネレーターが最終的な返答を送ると、ルーターはこの最終回答をユーザーに送ります。

さて、上記のステップに従って、複数のエージェントを持つワークフローを作成しましょう。

まず、langchainパッケージをすべてインストールする必要があります。

pip install langchain langchain\_openai langgraph langchain\_core langsmith langchain_experimental

データの保存(pandas)およびチャート作成(matplotlib)のためのいくつかのパッケージもインストールする必要があります。

pip install pandas matplotlib

次に、マルチエージェントワークフローを作成するために必要なライブラリをインポートします。

import json

from langchain_core.messages import (

AIMessage,

BaseMessage,

ChatMessage,

FunctionMessage,

HumanMessage,

)

from langchain.tools.render import format\_tool\_to\_openai\_function

from langchain_core.prompts import ChatPromptTemplate, MessagesPlaceholder

from langgraph.graph import END, StateGraph

from langgraph.prebuilt.tool_executor import ToolExecutor, ToolInvocation

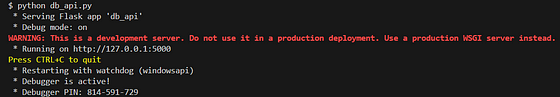

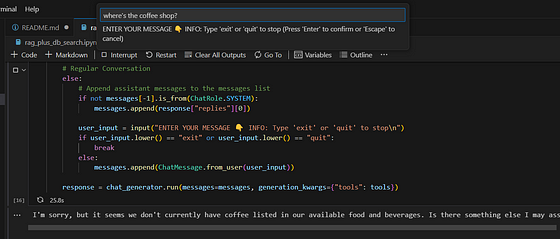

次に、ツールを設定します。インターネット検索ツールが必要です。それにはtavilyを使用します。

import os

os.environ\['TAVILY\_API\_KEY'\] = "<Your Tavily API Key here>"

from langchain_core.tools import tool

from langchain\_community.tools.tavily\_search import TavilySearchResults

tavily\_tool = TavilySearchResults(max\_results=5)

また、Pythonコードを実行するツールも必要とします。ここでは、langchain_experimental.utilitiesからPythonREPLというツールを使用します。

from langchain_experimental.utilities import PythonREPL

from typing import Annotated

repl = PythonREPL()

@tool

def python_repl(code: Annotated\[str, "The python code to execute to generate your chart."\]):

"""Use this to execute python code. If you want to see the output of a value, you should print it out with \`print(...)\`. This is visible to the user."""

try:

result = repl.run(code)

except BaseException as e:

return f"Failed to execute. Error: {repr(e)}"

return f"Succesfully executed:\\\\\\n\`python\\\\\\\\\\\\n{code}\\\\\\\\\\\\n\`\\\\\\nStdout: {result}"

ツールをリストに入れます。

tools = \[tavily\_tool, python\_repl\]

次に、状態のオブジェクトを作成します。この状態はメッセージのリストになります。これらのメッセージは一つのノードから別のノードに送信されます。

import operator

from typing import Annotated, List, Sequence, Tuple, TypedDict, Union

from langchain.agents import create\_openai\_functions_agent

from langchain.tools.render import format\_tool\_to\_openai\_function

from langchain_core.prompts import ChatPromptTemplate, MessagesPlaceholderfrom langchain_openai import ChatOpenAI

from typing_extensions import TypedDict\# This defines the object that is passed between each node

\# in the graph. We will create different nodes for each agent and tool

class AgentState(TypedDict):

messages: Annotated\[Sequence\[BaseMessage\], operator.add\]

sender: str

メッセージの内容に応じてツールを選択します。選ばれたツールをメッセージと共に実行するtool_nodeという関数を作成します。

tool_executor = ToolExecutor(tools)

def tool_node(state):

"""This runs tools in the graph It takes in an agent action and calls that tool and returns the result."""

messages = state\["messages"\]

# Based on the continue condition

# we know the last message involves a function call

last_message = messages\[-1\]

# We construct an ToolInvocation from the function_call

tool_input = json.loads(

last\_message.additional\_kwargs\["function_call"\]\["arguments"\]

)

# We can pass single-arg inputs by value

if len(tool\_input) == 1 and "\_\_arg1" in tool_input:

tool\_input = next(iter(tool\_input.values()))

tool\_name = last\_message.additional\_kwargs\["function\_call"\]\["name"\]

action = ToolInvocation(

tool=tool_name,

tool\_input=tool\_input,

)

# We call the tool_executor and get back a response

response = tool_executor.invoke(action)

# We use the response to create a FunctionMessage

function_message = FunctionMessage(

content=f"{tool_name} response: {str(response)}", name=action.tool

)

# We return a list, because this will get added to the existing list

return {"messages": \[function_message\]}

ツールノードの設定を行った後、状態からのメッセージ内容に基づいてデータを送信する場所を選択するルーターを作成しましょう。

def router(state):

messages = state\["messages"\]

last_message = messages\[-1\]

if "function_call" in last\_message.additional\_kwargs:

return "call_tool"

if "FINAL ANSWER" in last_message.content:

return "end"

return "continue"

次に、AIエージェントのリサーチャーとチャートジェネレーターを設定します。

まず、llmを作成しましょう。

from langchain_openai import ChatOpenAI

llm = ChatOpenAI(api_key="<Your API Key here>")

まず、'create_agent'という関数を作ります。この関数はエージェントを作成し、それに与えられたシステムメッセージを追加します。この関数は後で'researcher'と'chart generator'を作成するために使用します。

import json

from langchain_core.messages import (

AIMessage,

BaseMessage,

ChatMessage,

FunctionMessage,

HumanMessage,

)

from langchain\_core.utils.function\_calling import convert\_to\_openai_function

from langchain_core.prompts import ChatPromptTemplate, MessagesPlaceholder

from langgraph.graph import END, StateGraph

from langgraph.prebuilt.tool_executor import ToolExecutor, ToolInvocationdef create\_agent(llm, tools, system\_message: str):

"""Create an agent."""

functions = \[convert\_to\_openai_function(t) for t in tools\] prompt = ChatPromptTemplate.from_messages(

\[

(

"system",

"You are a helpful AI assistant, collaborating with other assistants."

" Use the provided tools to progress towards answering the question."

" If you are unable to fully answer, that's OK, another assistant with different tools "

" will help where you left off. Execute what you can to make progress."

" If you or any of the other assistants have the final answer or deliverable,"

" prefix your response with FINAL ANSWER so the team knows to stop."

" You have access to the following tools: {tool\_names}.\\\\\\n{system\_message}",

),

MessagesPlaceholder(variable_name="messages"),

\]

)

prompt = prompt.partial(system\_message=system\_message)

prompt = prompt.partial(tool_names=", ".join(\[tool.name for tool in tools\]))

return prompt | llm.bind_functions(functions)

次に、メッセージと送信者の名前を追加するタスクを行うagent_node関数を作成します。これはルーティングの目的で使用されます。

def agent_node(state, agent, name):

result = agent.invoke(state)

if isinstance(result, FunctionMessage):

pass

else:

result = HumanMessage(**result.dict(exclude={"type", "name"}), name=name)

return {

"messages": \[result\],

"sender": name,

}

さて、研究者エージェントとチャート生成エージェントを作成します。

research\_agent= create\_agent(

llm,

\[tavily_tool\],

system_message="You should provide accurate data for the chart generator to use.",

)

chart\_agent= create\_agent(

llm,

\[python_repl\],

system_message="Any charts you display will be visible by the user.",

)

次に、 'research_agent'と 'chart_agent'の関数を単純化して、 'research_node'と 'chart_node'の関数を形成します。既存の関数から新しい関数 'agent_node'を導き出すために 'functools'ライブラリを使用します。

import functools

research\_node= functools.partial(agent\_node, agent=research_agent, name="Researcher")

chart\_node= functools.partial(agent\_node, agent=chart_agent, name="Chart Generator")

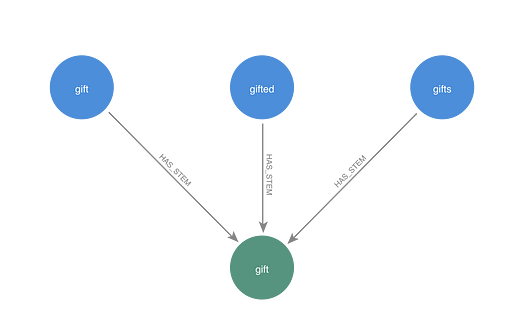

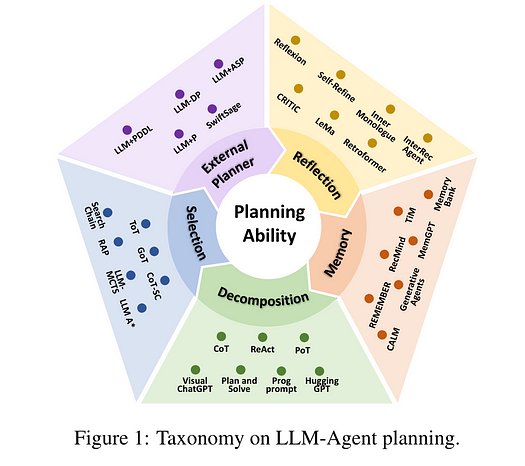

すべてのノード、つまりresearch_node、chart_node、tool_nodeを、「workflow」と呼ぶグラフに配置することができます。また、特定の条件に基づいてメッセージを送信する条件付きエッジを追加します。Researcherノードを開始点として設定し、ユーザーの入力が最初に研究者に行くようにします。最後に、グラフをコンパイルします。

workflow= StateGraph(AgentState)

workflow.add\_node("Researcher", research\_node)

workflow.add\_node("Chart Generator", chart\_node)

workflow.add\_node("call\_tool", tool_node)workflow.add\_conditional\_edges(

"Researcher",

router,

{"continue": "Chart Generator", "call\_tool": "call\_tool", "end": END},

)

workflow.add\_conditional\_edges(

"Chart Generator",

router,

{"continue": "Researcher", "call\_tool": "call\_tool", "end": END},

)workflow.add\_conditional\_edges(

"call_tool",

\# Each agent node updates the 'sender' field# the tool calling node does not, meaning

\# this edge will route back to the original agent# who invoked the tool

lambda x: x\["sender"\],

{

"Researcher": "Researcher",

"Chart Generator": "Chart Generator",

},

)

workflow.set\_entry\_point("Researcher")

graph= workflow.compile()

これで、マルチエージェントワークフローを呼び出す準備ができました。

for s in graph.stream(

{

"messages": \[

HumanMessage(

content="Fetch the Malaysia's GDP over the past 5 years,"

" then draw a line graph of it."

" Once you code it up, finish."

)

\],

},

{"recursion_limit": 150},

):

print(s)

print("----")

アウトプットは次のとおりです。

{'Researcher': {'messages': \[HumanMessage(content='', additional\_kwargs={'function\_call': {'arguments': '{"query":"Malaysia GDP by year"}', 'name': 'tavily\_search\_results\_json'}}, response\_metadata={'token\_usage': {'completion\_tokens': 22, 'prompt\_tokens': 221, 'total\_tokens': 243}, 'model\_name': 'gpt-3.5-turbo', 'system\_fingerprint': 'fp\_3b956da36b', 'finish\_reason': 'function\_call', 'logprobs': None}, name='Researcher', id='run-313ac64c-fed0-4505-b00d-715c7ff0aa59-0', tool\_calls=\[\], invalid\_tool\_calls=\[\])\], 'sender': 'Researcher'}}

\-\-\-\-

{'call\_tool': {'messages': \[FunctionMessage(content="tavily\_search\_results\_json response: \[{'url': '<https://data.worldbank.org/indicator/NY.GDP.MKTP.KD.ZG?locations=MY>', 'content': 'GDP growth (annual %) - Malaysia from The World Bank: Data.'}, {'url': '<https://tradingeconomics.com/malaysia/gdp>', 'content': 'GDP in Malaysia averaged 109.79 USD Billion from 1960 until 2022, reaching an all time high of 407.03 USD Billion in 2022 and a record low of 1.90 USD Billion\\\\\\xa0...'}, {'url': '<https://www.macrotrends.net/global-metrics/countries/MYS/malaysia/gdp-gross-domestic-product>', 'content': 'Malaysia gdp for 2019 was $365.18B, a 1.78% increase from 2018. Download Historical Data Save as Image\\\\\\xa0...'}, {'url': '<https://data.worldbank.org/indicator/NY.GDP.MKTP.CD?locations=MY>', 'content': '1960 1980 2000 2020 0.00 225b 450b Malaysia. 1960 - 2022. 2022, 2021, 2020, 2019, 2018, 2017, 2016, 2015, 2014, 2013, 2012, 2011, 2010, 2009, 2008, 2007\\\\\\xa0...'}, {'url': '<https://www.worldometers.info/gdp/malaysia-gdp/>', 'content': 'Nominal (current) Gross Domestic Product (GDP) of Malaysia is $406,306,000,000 (USD) as of 2022. · Real GDP (constant, inflation adjusted) of Malaysia reached\\\\\\xa0...'}\]", name='tavily\_search\_results_json')\]}}

\-\-\-\-

{'Researcher': {'messages': \[HumanMessage(content='', additional\_kwargs={'function\_call': {'arguments': '{"query":"Malaysia GDP historical data"}', 'name': 'tavily\_search\_results\_json'}}, response\_metadata={'token\_usage': {'completion\_tokens': 22, 'prompt\_tokens': 632, 'total\_tokens': 654}, 'model\_name': 'gpt-3.5-turbo', 'system\_fingerprint': 'fp\_3b956da36b', 'finish\_reason': 'function\_call', 'logprobs': None}, name='Researcher', id='run-442c7d99-8b3c-4a32-99ec-e0739ac059dd-0', tool\_calls=\[\], invalid\_tool\_calls=\[\])\], 'sender': 'Researcher'}}

\-\-\-\-

{'call\_tool': {'messages': \[FunctionMessage(content='tavily\_search\_results\_json response: \[{\\\'url\\\': \\\'<https://data.worldbank.org/indicator/NY.GDP.MKTP.KD.ZG?locations=MY&view=chart\\\>', \\\'content\\\': \\\'GDP growth (annual %) - Malaysia. World Bank national accounts data, and OECD National Accounts data files. License : CC BY-4.0. LineBarMap. Also Show Share Details. Label. 1961 - 2022.\\\'}, {\\\'url\\\': \\\'<https://tradingeconomics.com/malaysia/gdp\\\>', \\\'content\\\': \\\'The Gross Domestic Product (GDP) in Malaysia was worth 407.03 billion US dollars in 2022, according to official data from the World Bank. The GDP value of Malaysia represents 0.17 percent of the world economy. This page provides - Malaysia GDP - actual values, historical data, forecast, chart, statistics, economic calendar and news.\\\'}, {\\\'url\\\': \\\'<https://www.macrotrends.net/global-metrics/countries/MYS/malaysia/gdp-growth-rate\\\>', \\\'content\\\': \\\'Malaysia gdp growth rate for 2022 was 8.65%, a 5.35% increase from 2021. Malaysia gdp growth rate for 2021 was 3.30%, a 8.75% increase from 2020. Malaysia gdp growth rate for 2020 was -5.46%, a 9.87% decline from 2019. Malaysia gdp growth rate for 2019 was 4.41%, a 0.43% decline from 2018. Download Historical Data. Save as Image.\\\'}, {\\\'url\\\': \\\'<https://data.worldbank.org/indicator/NY.GDP.MKTP.CD?locations=MY&view=chart\\\>', \\\'content\\\': \\\'All Countries and Economies. Country. Most Recent Year. Most Recent Value(Millions) GDP (current US$) - Malaysia from The World Bank: Data.\\\'}, {\\\'url\\\': \\\'<https://www.macrotrends.net/global-metrics/countries/MYS/malaysia/gdp-gross-domestic-product\\\>', \\\'content\\\': "Malaysia gdp for 2022 was $407.03B, a 8.88% increase from 2021. Malaysia gdp for 2021 was $373.83B, a 10.78% increase from 2020. Malaysia gdp for 2020 was $337.46B, a 7.59% decline from 2019. Malaysia gdp for 2019 was $365.18B, a 1.78% increase from 2018. GDP at purchaser\\\'s prices is the sum of gross value added by all resident producers in the ..."}\]', name='tavily\_search\_results_json')\]}}

\-\-\-\-

{'Researcher': {'messages': \[HumanMessage(content="Based on the search results, I found the GDP data for Malaysia for the past 5 years as follows:\\\n\\\n- 2018: $365.18 billion\\\n- 2019: $337.46 billion\\\n- 2020: $373.83 billion\\\n- 2021: $407.03 billion\\\n- 2022: $407.03 billion\\\n\\\nNow, I will proceed to create a line graph to visualize this data.\\\nI will now generate a line graph to visualize Malaysia's GDP over the past 5 years.", response\_metadata={'token\_usage': {'completion\_tokens': 113, 'prompt\_tokens': 1210, 'total\_tokens': 1323}, 'model\_name': 'gpt-3.5-turbo', 'system\_fingerprint': 'fp\_3b956da36b', 'finish\_reason': 'stop', 'logprobs': None}, name='Researcher', id='run-e498d73b-c688-4e38-aa9b-b4cfa39c34c7-0', tool\_calls=\[\], invalid\_tool\_calls=\[\])\], 'sender': 'Researcher'}}

\-\-\-\-

{'Chart Generator': {'messages': \[HumanMessage(content='', additional\_kwargs={'function\_call': {'arguments': '{"code":"import matplotlib.pyplot as plt\\\\\\n\\\\\\ndata = {\\\\\\n \\\'Year\\\': \[2018, 2019, 2020, 2021, 2022\],\\\\\\n \\\'GDP (in billion USD)\\\': \[365.18, 337.46, 373.83, 407.03, 407.03\]\\\\\\n}\\\\\\n\\\\\\nplt.figure(figsize=(10, 6))\\\\\\nplt.plot(data\[\\\'Year\\\'\], data\[\\\'GDP (in billion USD)\\\'\], marker=\\\'o\\\', color=\\\'b\\\', linestyle=\\\'-\\\', linewidth=2)\\\\\\nplt.title(\\\'Malaysia GDP Over the Past 5 Years\\\')\\\\\\nplt.xlabel(\\\'Year\\\')\\\\\\nplt.ylabel(\\\'GDP (in billion USD)\\\')\\\\\\nplt.grid(True)\\\\\\nplt.show()"}', 'name': 'python\_repl'}}, response\_metadata={'token\_usage': {'completion\_tokens': 175, 'prompt\_tokens': 1338, 'total\_tokens': 1513}, 'model\_name': 'gpt-3.5-turbo', 'system\_fingerprint': 'fp\_3b956da36b', 'finish\_reason': 'function\_call', 'logprobs': None}, name='Chart Generator', id='run-11c4756f-097b-4733-8ecf-6091f5be5bd4-0', tool\_calls=\[\], invalid\_tool\_calls=\[\])\], 'sender': 'Chart Generator'}}

\-\-\-\-

{'call_tool': {'messages': \[FunctionMessage(content="python_repl response: Succesfully executed:\\\\\\n\`python\\\\\\\\\\\\nimport matplotlib.pyplot as plt\\\n\\\ndata = {\\\n 'Year': \[2018, 2019, 2020, 2021, 2022\],\\\n 'GDP (in billion USD)': \[365.18, 337.46, 373.83, 407.03, 407.03\]\\\n}\\\n\\\nplt.figure(figsize=(10, 6))\\\nplt.plot(data\['Year'\], data\['GDP (in billion USD)'\], marker='o', color='b', linestyle='-', linewidth=2)\\\nplt.title('Malaysia GDP Over the Past 5 Years')\\\nplt.xlabel('Year')\\\nplt.ylabel('GDP (in billion USD)')\\\nplt.grid(True)\\\nplt.show()\\\\\\\\\\\\n\`\\\\\\nStdout: ", name='python_repl')\]}}

\-\-\-\-

{'Chart Generator': {'messages': \[HumanMessage(content="The line graph showing Malaysia's GDP over the past 5 years has been successfully generated. The graph displays the GDP (in billion USD) on the y-axis and the years from 2018 to 2022 on the x-axis. The GDP values are plotted as points connected by lines.\\\n\\\nIs there anything else you would like to analyze or any other assistance needed?", response_metadata={'token_usage': {'completion_tokens': 75, 'prompt_tokens': 1514, 'total_tokens': 1589}, 'model_name': 'gpt-3.5-turbo', 'system_fingerprint': 'fp_3b956da36b', 'finish_reason': 'stop', 'logprobs': None}, name='Chart Generator', id='run-a6d15c89-6cb8-4f98-9cbb-67bb92214dc5-0', tool\_calls=\[\], invalid\_tool_calls=\[\])\], 'sender': 'Chart Generator'}}

\-\-\-\-

{'Researcher': {'messages': \[HumanMessage(content="I have successfully generated the line graph showing Malaysia's GDP over the past 5 years. If you have any more data to analyze or need further assistance, feel free to let me know!", response_metadata={'token_usage': {'completion_tokens': 39, 'prompt_tokens': 1579, 'total_tokens': 1618}, 'model_name': 'gpt-3.5-turbo', 'system_fingerprint': 'fp_3b956da36b', 'finish_reason': 'stop', 'logprobs': None}, name='Researcher', id='run-9c1709e6-f6ee-4a8c-b0ae-f363d65a5a2f-0', tool\_calls=\[\], invalid\_tool_calls=\[\])\], 'sender': 'Researcher'}}

\-\-\-\-

{'Chart Generator': {'messages': \[HumanMessage(content="Great! If you have any more data to analyze or any other tasks you'd like assistance with, feel free to ask. I'm here to help!", response_metadata={'token_usage': {'completion_tokens': 32, 'prompt_tokens': 1634, 'total_tokens': 1666}, 'model_name': 'gpt-3.5-turbo', 'system_fingerprint': 'fp_3b956da36b', 'finish_reason': 'stop', 'logprobs': None}, name='Chart Generator', id='run-1f869abb-930c-4b19-ab7e-c068a407f134-0', tool\_calls=\[\], invalid\_tool_calls=\[\])\], 'sender': 'Chart Generator'}}

\-\-\-\-

{'Researcher': {'messages': \[HumanMessage(content="I'm glad the line graph for Malaysia's GDP over the past 5 years was successfully generated. If you have any more data to analyze or any other tasks you'd like assistance with, feel free to ask. I'm here to help!", response_metadata={'token_usage': {'completion_tokens': 50, 'prompt_tokens': 1656, 'total_tokens': 1706}, 'model_name': 'gpt-3.5-turbo', 'system_fingerprint': 'fp_3b956da36b', 'finish_reason': 'stop', 'logprobs': None}, name='Researcher', id='run-4c614614-5fc6-4d6b-abd8-5b1b85607f5a-0', tool\_calls=\[\], invalid\_tool_calls=\[\])\], 'sender': 'Researcher'}}

\-\-\-\-

{'Chart Generator': {'messages': \[HumanMessage(content='Thank you! If you have any more data to analyze or if you need assistance with any other tasks in the future, feel free to reach out. Have a great day!', response_metadata={'token_usage': {'completion_tokens': 36, 'prompt_tokens': 1722, 'total_tokens': 1758}, 'model_name': 'gpt-3.5-turbo', 'system_fingerprint': 'fp_3b956da36b', 'finish_reason': 'stop', 'logprobs': None}, name='Chart Generator', id='run-659e7259-1906-4c07-8bb5-53c8d6ac7dd2-0', tool\_calls=\[\], invalid\_tool_calls=\[\])\], 'sender': 'Chart Generator'}}

\-\-\-\-

{'Researcher': {'messages': \[HumanMessage(content='Thank you! If you have any more data to analyze or if you need assistance with any other tasks in the future, feel free to reach out. Have a great day!', response_metadata={'token_usage': {'completion_tokens': 36, 'prompt_tokens': 1748, 'total_tokens': 1784}, 'model_name': 'gpt-3.5-turbo', 'system_fingerprint': 'fp_3b956da36b', 'finish_reason': 'stop', 'logprobs': None}, name='Researcher', id='run-f87114d6-08aa-4a54-8490-1a1145a30263-0', tool\_calls=\[\], invalid\_tool_calls=\[\])\], 'sender': 'Researcher'}}

\-\-\-\-

{'Chart Generator': {'messages': \[HumanMessage(content='Great collaboration! If you have any more questions or need assistance in the future, feel free to ask. Have a wonderful day!', response_metadata={'token_usage': {'completion_tokens': 27, 'prompt_tokens': 1800, 'total_tokens': 1827}, 'model_name': 'gpt-3.5-turbo', 'system_fingerprint': 'fp_3b956da36b', 'finish_reason': 'stop', 'logprobs': None}, name='Chart Generator', id='run-b12ec2b6-61bb-485c-81cf-279ade302e02-0', tool\_calls=\[\], invalid\_tool_calls=\[\])\], 'sender': 'Chart Generator'}}

\-\-\-\-

{'Researcher': {'messages': \[HumanMessage(content="Thank you! It was a pleasure collaborating with you. If you have any more questions or need assistance in the future, don't hesitate to ask. Have a wonderful day!", response_metadata={'token_usage': {'completion_tokens': 36, 'prompt_tokens': 1817, 'total_tokens': 1853}, 'model_name': 'gpt-3.5-turbo', 'system_fingerprint': 'fp_3b956da36b', 'finish_reason': 'stop', 'logprobs': None}, name='Researcher', id='run-3c7cf207-ce49-416f-bb02-81a2a3410d5a-0', tool\_calls=\[\], invalid\_tool_calls=\[\])\], 'sender': 'Researcher'}}

\-\-\-\-

{'Chart Generator': {'messages': \[HumanMessage(content='It was a pleasure collaborating with you! If you have any more questions or need assistance in the future, feel free to reach out. Have a great day!', response_metadata={'token_usage': {'completion_tokens': 33, 'prompt_tokens': 1869, 'total_tokens': 1902}, 'model_name': 'gpt-3.5-turbo', 'system_fingerprint': 'fp_3b956da36b', 'finish_reason': 'stop', 'logprobs': None}, name='Chart Generator', id='run-1d5d0ed0-c20a-4745-a16f-6adcaa8c2c81-0', tool\_calls=\[\], invalid\_tool_calls=\[\])\], 'sender': 'Chart Generator'}}

\-\-\-\-

{'Researcher': {'messages': \[HumanMessage(content='Likewise! If you ever have more questions or need help in the future, feel free to ask. Have a fantastic day!', response_metadata={'token_usage': {'completion_tokens': 27, 'prompt_tokens': 1892, 'total_tokens': 1919}, 'model_name': 'gpt-3.5-turbo', 'system_fingerprint': 'fp_3b956da36b', 'finish_reason': 'stop', 'logprobs': None}, name='Researcher', id='run-bb88218f-ab2f-4ee5-b381-d75e1bd1d1cf-0', tool\_calls=\[\], invalid\_tool_calls=\[\])\], 'sender': 'Researcher'}}

\-\-\-\-

{'Chart Generator': {'messages': \[HumanMessage(content='Likewise! If you ever have more questions or need help in the future, feel free to ask. Have a fantastic day!', response_metadata={'token_usage': {'completion_tokens': 27, 'prompt_tokens': 1935, 'total_tokens': 1962}, 'model_name': 'gpt-3.5-turbo', 'system_fingerprint': 'fp_3b956da36b', 'finish_reason': 'stop', 'logprobs': None}, name='Chart Generator', id='run-50293d69-34ff-455d-8b34-3a20a0a1bb91-0', tool\_calls=\[\], invalid\_tool_calls=\[\])\], 'sender': 'Chart Generator'}}

\-\-\-\-

{'Researcher': {'messages': \[HumanMessage(content="I'm glad we were able to collaborate effectively! If you have any more questions or need assistance in the future, feel free to reach out. Have a wonderful day!", response_metadata={'token_usage': {'completion_tokens': 35, 'prompt_tokens': 1952, 'total_tokens': 1987}, 'model_name': 'gpt-3.5-turbo', 'system_fingerprint': 'fp_3b956da36b', 'finish_reason': 'stop', 'logprobs': None}, name='Researcher', id='run-67208ed1-0d31-4b43-b2e8-92619b806deb-0', tool\_calls=\[\], invalid\_tool_calls=\[\])\], 'sender': 'Researcher'}}

{'Researcher': {'messages': \[HumanMessage(content="Thank you! It was a pleasure collaborating with you. If you have any more questions or need assistance in the future, don't hesitate to ask. Have a wonderful day!", response_metadata={'token_usage': {'completion_tokens': 36, 'prompt_tokens': 2087, 'total_tokens': 2123}, 'model_name': 'gpt-3.5-turbo', 'system_fingerprint': 'fp_3b956da36b', 'finish_reason': 'stop', 'logprobs': None}, name='Researcher', id='run-bc8186f2-1f7e-477e-b1ff-0020c7171aa3-0', tool\_calls=\[\], invalid\_tool_calls=\[\])\], 'sender': 'Researcher'}}

\-\-\-\-

{'Chart Generator': {'messages': \[HumanMessage(content='FINAL ANSWER', response_metadata={'token_usage': {'completion_tokens': 4, 'prompt_tokens': 2139, 'total_tokens': 2143}, 'model_name': 'gpt-3.5-turbo', 'system_fingerprint': 'fp_3b956da36b', 'finish_reason': 'stop', 'logprobs': None}, name='Chart Generator', id='run-45177a17-7ae8-43b0-b73e-f9d3d5c5d456-0', tool\_calls=\[\], invalid\_tool_calls=\[\])\], 'sender': 'Chart Generator'}

お疲れ様です!マルチエージェントワークフローを作成しました。これで、複雑なタスクに取り組む複数のAIエージェントを持つ方向に進んでいます。

%2077bf2364b2f445d0b3e70ff2fc6d969a/Untitled.png)

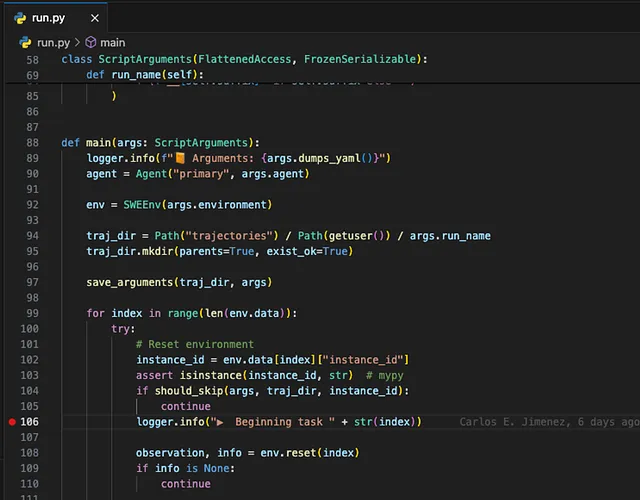

%2077bf2364b2f445d0b3e70ff2fc6d969a/Untitled%201.png)

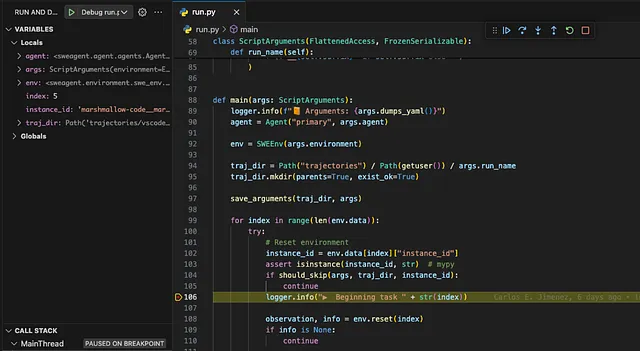

%2077bf2364b2f445d0b3e70ff2fc6d969a/Untitled%202.png)

%2077bf2364b2f445d0b3e70ff2fc6d969a/Untitled%203.png)

%2077bf2364b2f445d0b3e70ff2fc6d969a/Untitled%204.png)